深度学习中激活函数总结 - 知乎

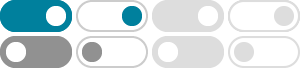

图7:Dice激活函数和PReLU的对比 4.5 RReLU RReLU (Randomized Leaky ReLU)的首次提出是在Kaggle比赛NDSB中,也是Leaky-ReLU的一个变体。 RReLU在训练的过程中, 是从均匀分布 中随 …

如何让onnx2caffe支持prelu层的转换? - 知乎

但prelu真正的需求是仅仅对负数操作。 所以scale_down的功能就是对参数的正数部分全部乘以 (1-a),把sclae_up和scale_down的结果加起来就最终完成了prelu的功能。

大型计算模型中常用的激活函数有哪些? - 知乎

Parametric ReLU (PReLU):PReLU是Leaky ReLU的一个变体,其负部分的斜率是可学习的参数,可以根据数据自动调整。 ELU(Exponential Linear Unit)函数:ELU函数在正数部分与ReLU相同,在 …

在残差网络中激活函数relu的使用,为什么不使用leakyrelu、rrule等改 …

Aug 5, 2019 · 何凯明 大神做过一个改进的激活函数PReLU,可以查查张欢论文。 即便如此,ReLU还是最好用最常用的 激活函数。用其他的激活函数在性能上没有很明显的提升,反而增加了计算复杂 …

在残差网络中激活函数relu的使用,为什么不使用leakyrelu、rrule等改 …

ReLU在残差网络中称王?——激活函数选择的深度剖析 核心结论: 【核心】在残差网络中, ReLU(Rectified Linear Unit) 凭借其 计算简单、加速收敛 的优势,仍是激活函数的首选,尽管存在 …

Pytorch torch.nn库以及nn与nn.functional有什么区别?

Oct 21, 2024 · tocrch.nn库 torch.nn是专门为神经网络设计的模块化接口 nn构建于autograd之上,可以用来定义和运行神经网络 nn.Parameter nn.Linear&nn.conv2d等等 nn.functional nn.Module …

目前来说relu 的几种变体rrelu elu leaky relu那个更好? - 知乎

非自适应:所有负区间共享固定斜率。 3. PReLU(Parametric ReLU) 提出背景 何恺明(Kaiming He)等人在2015年提出PReLU,将LeakyReLU的斜率 α 改为 可学习参数。 数学表达式 (α 通过反 …

深度学习调参有哪些技巧? - 知乎

时隔多年,在大模型领域也有点感觉了,分享一点小小心得,有兴趣的朋友可以交流交流。深度学习调参的参看下面哦。 先调prompt,保证让模型可以按照你想输出的样式先输出。如果怎么调都不行建议 …

如何看待何恺明、孙剑十年经典之作获 ICCV2025 最佳论文? - 知乎

值得一提的是,一篇曾由何恺明、张祥雨、任少卿和孙剑发表于十年前的论文,荣获Helmholtz Prize。 这篇论文堪称深度学习领域的里程碑,因提出PReLU等技术,让机器在ImageNet上识别错误率远超人 …

RNN 中为什么要采用 tanh,而不是 ReLU 作为激活函数? - 知乎

5. Parametric ReLU激活函数 (1)Parametric ReLU(PReLU)激活函数是一种修正线性单元(ReLU)的变种,它允许神经网络学习激活函数的参数,而不是使用固定的斜率。 通常,标准 …